O ano era 2014 e a Amazon (olha ela de novo aqui) desenvolvia um sistema de inteligência artificial que seria capaz de selecionar os melhores currículos no processo de recrutamento da companhia, selecionando cinco melhores candidatos dentre 100 currículos, tornando tudo mais ágil.

Não precisou de muito tempo e o algoritmo desenvolvido pela equipe de tecnologia da informação se mostrou uma fracasso.

O aprendizado de máquina baseado nos padrões de contratação dos últimos 10 anos da companhia classificava as mulheres, numa escala de 1 a 5, sempre com notas baixas.

A falha foi logo identificada.

Com o setor de tecnologia sendo dominado majoritariamente por homens, o sistema aprendeu (machine learning) que a preferência era por currículos do gênero masculino.

Mesmo quando a equipe corrigiu o erro, o sistema perpetuou outras maneiras de discriminar candidatos.

Tudo baseado nos padrões aprendidos com os dados.

Assim, em 2017, a equipe foi desligada devido a falta de esperança dos executivos em solucionar a questão. O algoritmo passou a ser usado de maneira muito mais restrita do que o planejamento ambicioso de selecionar currículos com agilidade e precisão.

Essa preocupação, no entanto, se torna ainda mais aguda com a popularização do reconhecimento facial de emoções.

- Inteligência imperfeita e aprendizado incorreto no reconhecimento de emoções

- Como ocorre viés na inteligência artificial

-

Por que é tão difícil consertar viés na inteligência artificial?

- 1) Porque a introdução do viés nem sempre é óbvia dentro da construção do modelo

- 2) Porque muitos dos processos de deep learning não são projetados para detectar viés

- 3) Porque a forma que os cientistas da computação são ensinados a definir problemas, muitas vezes, não é a melhor abordagem para problemas sociais

- 4) Porque não está muito claro como a ausência de viés deve ser

- Então como vamos superar o viés na inteligência artificial?

Inteligência imperfeita e aprendizado incorreto no reconhecimento de emoções

Um estudo da Dra. Lauren Rhue apontou preconceitos raciais sistemáticos, reproduzidos em dois programas de reconhecimento de emoções.

Ao utilizar 400 fotos de jogadores da NBA, a pesquisadora descobriu que os dois sistemas classificavam mais emoções negativas às pessoas negras, independente do quanto eles estavam sorrindo.

Enquanto o Face++ avaliava os jogadores negros como sentindo duas vezes mais raiva que os jogadores brancos, o Face API da Microsoft, avaliou os jogadores negros como três vezes mais desdenhosos que os jogadores brancos, embora nenhum deles estivesse expressando algum desses sentimentos negativos.

O estudo utilizou atletas com idade, porte físico, roupas semelhantes e fotos com enquadramento igual para comparar o reconhecimento das emoções.

Numa crescente preocupação sobre uso de reconhecimento facial, a autora concluiu que apesar dos algoritmos serem mais sofisticados do que já foram há algum tempo, ainda é prematuro utilizar essa tecnologia para chegar a conclusões sobre o que as pessoas estão sentindo com base nos movimentos faciais.

E o motivo é que, ao serem programados para captar modelos de comportamentos, os algoritmos são alimentos por dados. Antes de iniciar o treinamento da máquina, os dados são coletados, separados e classificados por pessoas.

Assim, a partir de um comportamento consciente ou inconsciente ao alimentar os dados, os algoritmos podem acabar replicando comportamentos indesejáveis dessas pessoas, como racismo, misoginia e homofobia.

“O resultado é a reprodução de discriminação e intolerância vistas na sociedade nas mais variadas formas”, aponta o AI Now 2019 Report.

Como ocorre viés na inteligência artificial

No artigo This is how AI bias really happens — and why it’s so hard to fix, que deu nome a este tópico, Karen Hao detalha como as falhas podem ocorrer no processo denominado deep learning, categoria em que a maioria das aplicações de inteligência artificial são baseadas.

Nós costumamos justificar o viés atribuindo culpa a um conjunto de dados de treinamento enviesado, mas conforme a autora, na realidade existem muitos outros fatores a serem considerados, e que podem ocorrer em outros estágios de coleta de dados, antes mesmo do processo de deep learning.

1) Definição do problema

Ao construir um modelo de deep learning, a primeira coisa que cientistas da computação fazem é decidir qual o objetivo da construção.

Por exemplo, uma empresa de cartão de crédito pode buscar avaliar se um cliente é ou não elegível para receber crédito.

Mas como traduzir o conceito de credibilidade para algo computável?

A empresa deve, por exemplo, decidir se quer maximizar a margem de lucro ou maximizar a quantidade de empréstimos pagos.

“O problema é que essas decisões são tomadas por diversas razões do negócio que vão além de justiça ou discriminação. Se o algoritmo identificar um padrão e descobrir que dar empréstimos de risco pode ser um caminho para maximizar o lucro, isso pode acabar criando um comportamento predatório que não era a intenção da empresa”, explica Solon Barocas, um professor na Cornell University especialista em justiça dentro de machine learning.

2) Coleta de dados

Nesta etapa, o viés pode ocorrer de duas maneiras:

I) Os dados coletadas não são uma boa representação da realidade

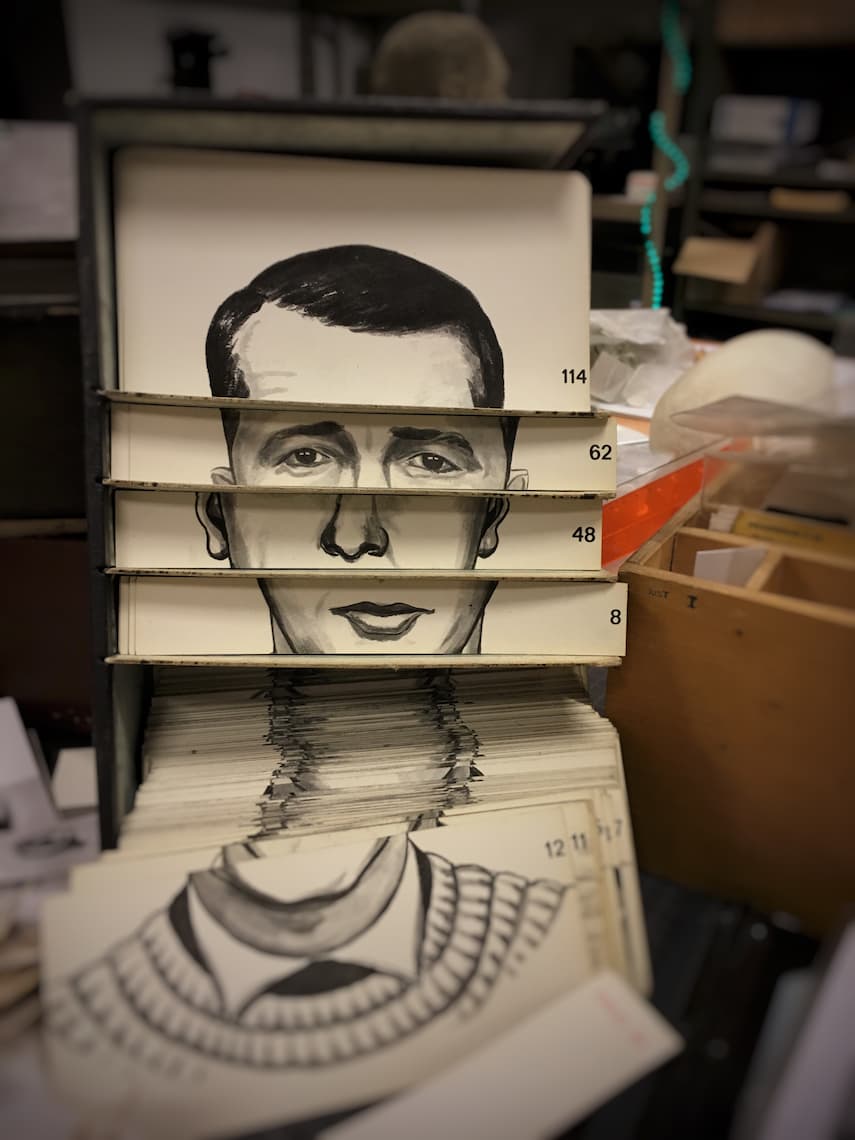

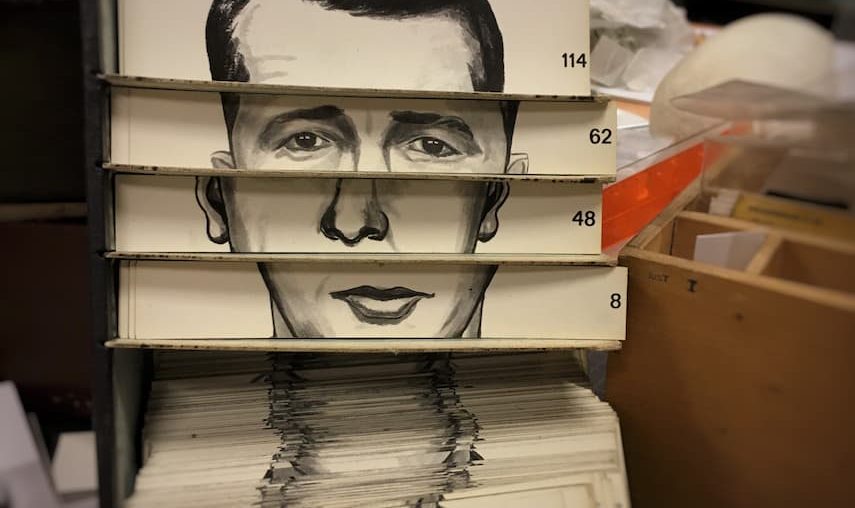

Se o algoritmo, por exemplo, é treinado com mais fotos de pessoas brancas do que negras, o sistema de reconhecimento facial seria consequentemente pior em reconhecer rostos e emoções de pessoas negras.

II) Os dados coletados refletem preconceitos existentes

O segundo caso é o que aconteceu com a Amazon.

O sistema foi treinado com históricos anteriores de contratação que favoreciam homens às mulheres. Assim, a ferramenta de recrutamento identificou o padrão e começou a penalizar candidatas mulheres.

3) Preparação dos dados

Por fim, é possível introduzir viés durante a etapa de preparação dos dados que envolve selecionar quais atributos e/ou variáveis o algoritmo deve considerar.

Na ferramenta de recrutamento da Amazon, por exemplo, poderiam ser considerados o gênero do candidato, o nível de educação e os anos de experiência. Isso é o que as pessoas costumam chamar de “arte” do deep learning: escolher quais atributos ignorar ou considerar e o que vai influenciar na precisão do seu modelo.

Mas, enquanto, o impacto dos atributos sobre a precisão é fácil de ser medido, o impacto sobre o viés do modelo não é.

Por que é tão difícil consertar viés na inteligência artificial?

Conforme o estudo, quatro fatores respondem a essa pergunta.

1) Porque a introdução do viés nem sempre é óbvia dentro da construção do modelo

Mesmo que você identifique o viés, muitas vezes é difícil ver em que momento ele foi introduzido.

No caso da Amazon, mesmo depois que os engenheiros descobriram que a ferramenta estava penalizando mulheres, após reprogramar para que o algoritmo ignorasse palavras com gênero “women” explícito, o sistema continuou a considerar palavras cujo verbos eram altamente correlacionados a homens e não a mulheres, utilizando essa informação para tomar decisões.

2) Porque muitos dos processos de deep learning não são projetados para detectar viés

Na prática, os cientistas dividem os dados em dois conjuntos aleatórios, um de treinamento e um de validação.

Assim, os dados utilizados para testar a performance do modelo tem o mesmo viés que os dados utilizados para treiná-lo. Portanto, ele irá falhar ao tentar indicar resultados enviesados.

3) Porque a forma que os cientistas da computação são ensinados a definir problemas, muitas vezes, não é a melhor abordagem para problemas sociais

Você não pode, por exemplo, definir um problema para um sistema utilizado pela justiça criminal e aplicá-lo também para recrutamento, pois isso seria completamente fora de contexto social.

Dessa forma, cientistas têm o dever e direito de saber para que estão desenvolvendo algoritmos.

4) Porque não está muito claro como a ausência de viés deve ser

Enquanto que em outras áreas a definição de justiça é compreendido como algo que pode mudar ao longo do tempo, o campo da computação entende que isso deveria ser algo a ser consertado, com a diferença que na computação é necessário definir o conceito de justiça em termos matemáticos.

Então como vamos superar o viés na inteligência artificial?

Durante as extensas 100 páginas de relatório AI Now 2019 Report, pesquisadores apontaram as principais causas dentro de um cenário composto majoritariamente por pouca diversidade.

Logo, os dados podem ser tão tendenciosos quanto as pessoas.

Apenas 18% dos palestrantes de conferências de IA são mulheres. Na universidades, 80% dos professores de IA são homens, e os dados sugerem que a questão é ainda pior se considerado a representação por raça ou etnia.

As informações demonstram que a falta de diversidade resulta no viés incorporado à indústria de tecnologia, tendo como consequência a discriminação prejudicial.

Fatores empíricos como em qual localidade a IA produzida será implantada, para qual finalidade esses sistemas serão utilizados, se eles funcionam e quais comunidades correm risco de viés são danos que raramente são discutidos no discurso sobre quem está ganhando a “corrida de IA”.

Enquanto na China a leitura facial já é usada na segurança pública e o país caminha para implementar o reconhecimento de emoções em estações de transporte para detectar suspeitos, na Califórnia houve pausa no uso de algumas técnicas de análise de emoções, pois os programas ainda não tem comprovação científica.

O relatório aponta a necessidade que estudiosos dessa área avaliem melhor os modelos normativos codificados nos sistemas de IA, e quais podem ser as conseqüências da aplicação dessas normas.

“Evidências científicas atuais sugerem que sua eficácia não se sustenta. Precisamos examinar por que as entidades estão usando tecnologia defeituosa para fazer avaliações sobre o caráter com base na aparência física”, diz o documento.